El estimador de Nadaraya-Watson es uno de los mecanismos de Regresión no paramétrica más prestigiosos. Usa un método Kernel de estimación de funciones de densidad. Un Kernel muy usual es la distribución Normal. Por ejemplo una N(0, 1). Al parámetro h se le denomina ventana y, en realidad, modifica la dispersión de la Normal, si es ésta la que actúa de Kernel. Es una forma original de construir una estimación de la variable dependiente «y» a partir de un valor de una variable independiente «x», basándose exclusivamente en la posición de los valores de la muestra que tenemos.

Se trata de un mecanismo de construcción de la variable «y» ponderando los valores muestrales de esta variable según la distancia que haya desde el valor de «x» a los valores muestrales de la variable independiente. La ponderació se materializa mediante el numerador del Kernel. Supongamos que éste sea la N(0, 1), entonces si el valor de «x» está cerca de un valor muestral de la variable independiente la resta será un valor próximo a cero y tendrá en la Normal un valor grande. Sin embargo, los valores alejados darán restas grandes en valor absoluto y en la Normal tendrá un valor próximo a cero. Observemos, pues, que el valor de «y» para esa «x» estará muy influido por los valores muestrales cercanos.

Archivo de la categoría: HERBARIO

Test de Kolmogorov de bondad de ajuste a una distribución normal

Test de Fisher de igualdad de varianzas

Correlación de Kendall

Recordemos los siguiente: Cuando en Estadística se escriben tres líneas paralelas horizontales a la derecha de un cálculo, de un estadístico, y a continuación se escribe una determinada distribución nos referimos a que tal estadístico sigue esa distribución. Si se pone encima de esas tres líneas algún símbolo significa que esa distribución se cumple si lo que se escribe allí es cierto. En este caso se escriben dos cosas: 1) Ho, lo que nos indica que este estadístico sigue esa distribución si es cierta la Ho. 2) Mayor o igual a 8, lo que significa que este estadístico sigue esa distribución si el tamaño de muestra es mayor o igual a 8.

Correlación de Pearson

La correlación de Pearson es la medida del grado de relación entre variables cuantitativas más usado. Es especialmente apropiado usarlo en variables con distribución normal porque el contraste de hipótesis a través del cual se valora su significación tiene un estadístico de test que sigue la distribución que sigue en condiciones de normalidad de las variables. Por eso si no se cumple la normalidad o si las variables son ordinales es más apropiado o usar la correlación de Spearman o la correlación de Kendall.

El cálculo de la correlación en una muestra se suele representar con una r, y es el cociente de la covarianza muestral respecto al producto de las desviaciones muestrales de cada una de las dos variables, como puede observarse a continuación.

En el dibujo adjunto se plantea, además del cálculo de la correlación r, el contraste de hipótesis sobre la correlación poblacional, con el estadístico de test que se usa y la distribución que ese estadístico sigue bajo la Hipótesis nula.

Test de la t de Student para muestras independientes y varianzas iguales

El Test de la t de Student para muestras independientes y varianzas iguales supone normalidad de la variable analizada e igualdad de varianzas. Cosa que se habrá comprobado previamente puesto que, de lo contrario, las conclusiones del proceso de decisión pueden ser erróneas.

(Cuando en Estadística se escriben tres líneas paralelas horizontales a la derecha de un cálculo, de un estadístico, y a continuación se escribe una determinada distribución nos referimos a que tal estadístico sigue esa distribución. Si se pone encima de esas tres líneas el símbolo Ho nos referimos que esta distribución concreta se sigue en el caso de ser cierta la Ho)

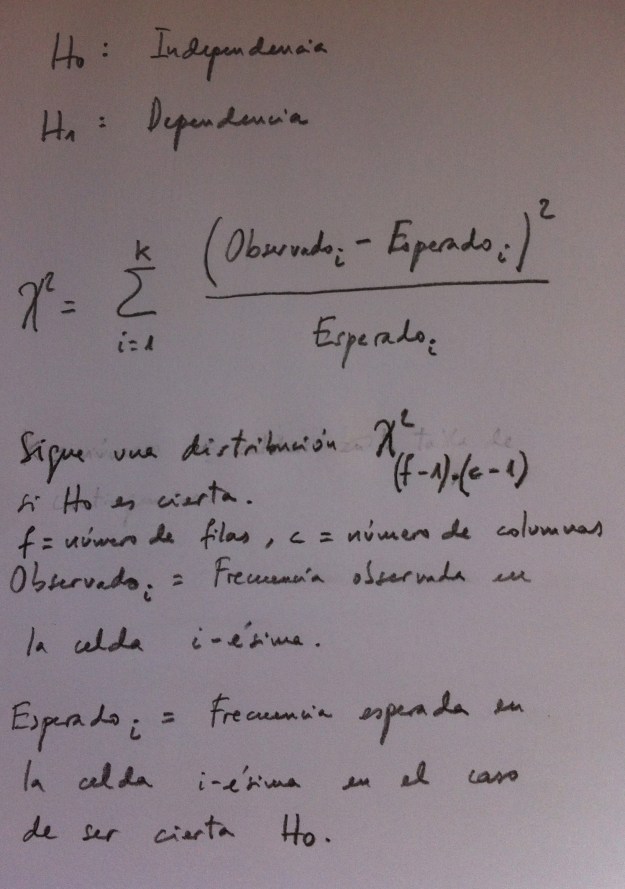

Test de la ji-cuadrado para tablas de contingencias

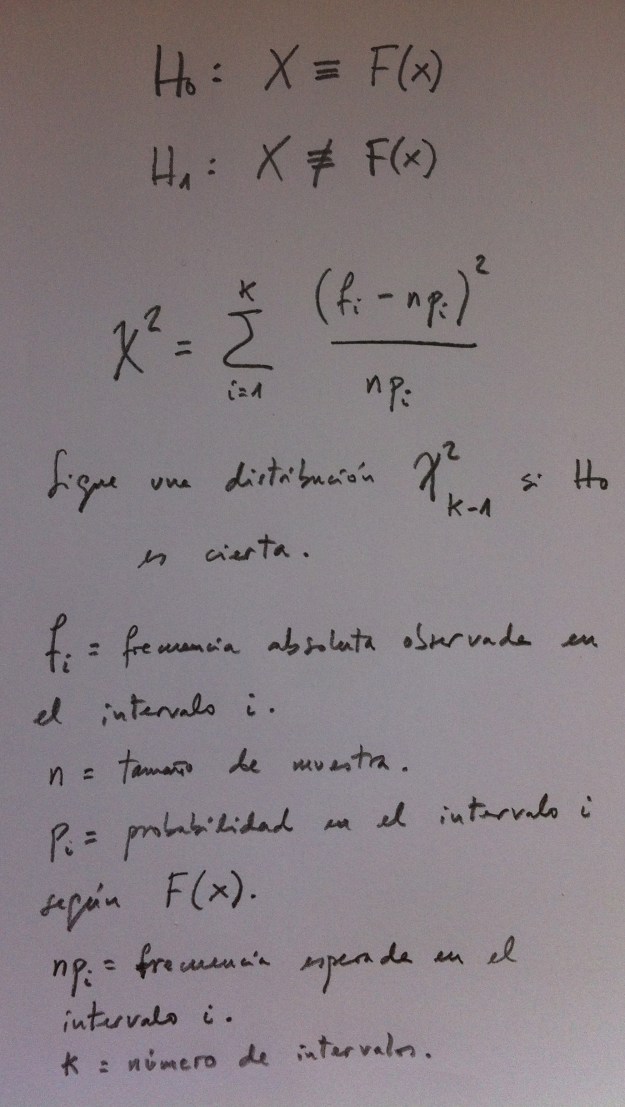

Test de la ji-cuadrado de ajuste a una distribución

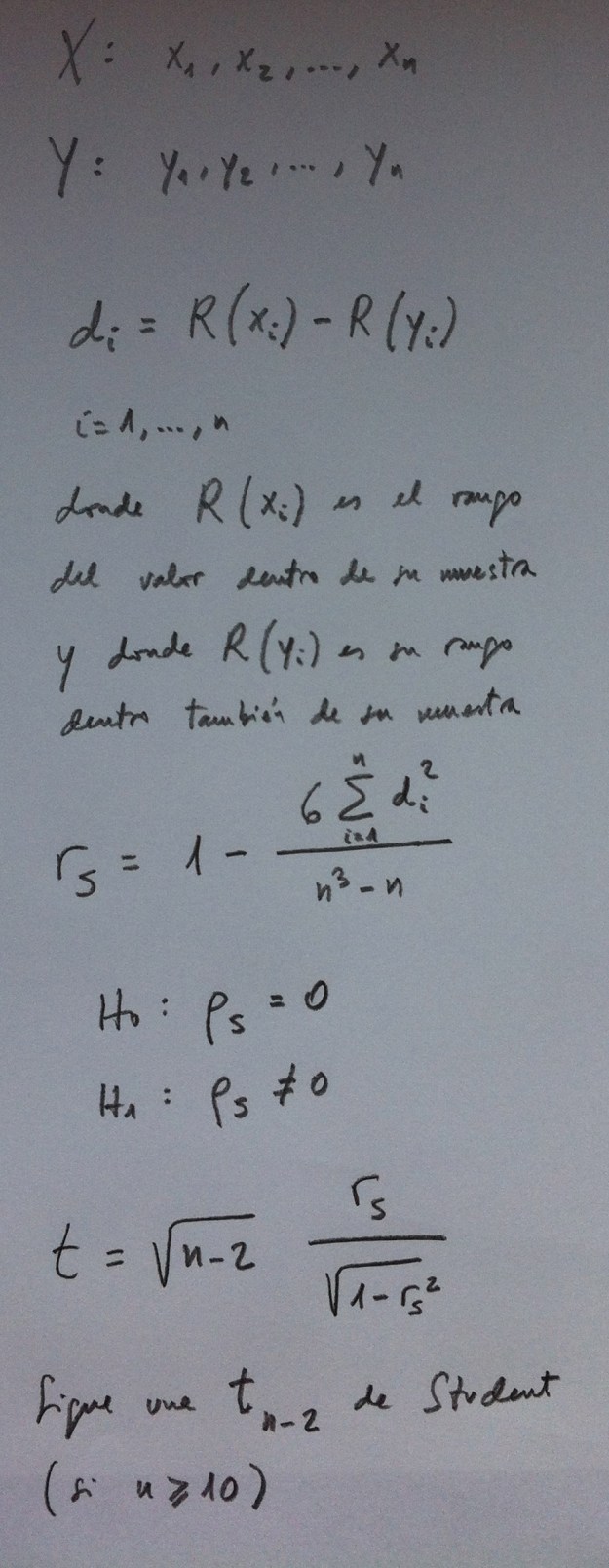

Correlación de Spearman

La correlación de Spearman es una de las correlaciones no paramétricas más usadas. Tenemos la muestra con las dos variables medidas (X e Y) y lo que hacemos es sustituir los valores muestrales por sus rangos. A partir de aquí se calcula individuo por individuo la diferencias de rangos respectivos del valor de la variable X y del valor de la variable Y y se calcula el estadístico de test para comprobar si podemos rechazar la Hipótesis nula de correlación cero o si debemos mantener lo afirmado en esa Hipótesis.

Voy a mostrar como se transforma una muestra en sus rangos: Supongamos la muestra siguiente: (3, 5, 0, 8, 6). La muestra en rangos sería: (2, 3, 1, 5, 4). Hemos sustituido el valor muestral por el orden ordinal que le corresponde en la muestra. Si hay empates se pone el rango promedio. Por ejemplo: (3, 5, 0, 8, 5) sería (2, 3.5, 1, 5, 3.5).

Test de Belssey, Kuh y Welsch

La multicolinealidad genera Error estándar; o sea, aumenta la dispersión de las predicciones:

El Test de Belsey, Kuh y Welsch permite detectar un exceso de colinealidad. Si para algún valor propio de la matriz de varianzas-covarianzas el valor del cálculo de la raíz cuadrada del cociente entre el valor máximo y ese valor propio es mayor que 30 se entiende que tenemos un exceso de colinealidad. Entre 5-10 la colinealidad es debil y entre 10-30 todavía no es lo sufiencientemente fuerte como para resultar no aceptable.

A este valor calculado se le suele llamar, también, índice de condición.